Psychologie et technologie

Introduction : Une fausse question, une vraie inquiétude

De nombreux consultants, en particulier les jeunes, m’avoue régulièrement utiliser chatGPT, ou tout autres intelligences artificielles dans un souci d’assistance psychologique. Ils se sentent généralement compris, non juger et plutôt bien conseillés.

Se demander si ChatGPT peut remplacer un accompagnement psychologique, c’est poser une question à la fois erronée et symptomatique. Erronée, car elle confond deux ordres de réalité, à savoir celui du vivant et celui du calcul. Symptomatique, car elle révèle la tentation moderne de substituer à la rencontre humaine, toujours fragile, souvent différée, incertaine et exigeante. En apparence l’I.A fait la promesse d’une relation sans risque, immédiatement disponible, gratuite et parfaitement adaptée.

Or derrière cette interrogation, se cache à mon sens une question beaucoup plus métaphysique : qu’est-ce qu’une rencontre réelle transforme vraiment ?

Dans un monde saturé de dispositifs relationnels artificiels, l’enjeu n’est plus seulement celui de la performance technique, mais celui de la vérité de la relation. Car la relation d’accompagnement psychique, dans son essence, ne repose pas seulement sur la parole, mais également sur la présence, pas seulement sur l’écoute, mais sur la résonance, c’est-à-dire sur cette vibration partagée où chacun se sent touché et transformé par l’autre.

Ce concept de résonance, développé notamment par le sociologue et philosophe allemand Hartmut Rosa, s’oppose à celui d’aliénation et désigne une forme de relation vivante entre un sujet et le monde.Il s’oppose à la simple interaction fonctionnelle ou instrumentale. L’aliénation est pour lui définie comme « une forme spécifique de relation au monde dans laquelle le sujet et le monde sont indifférents ou hostiles (répulsifs) l’un à l’autre et donc déconnectés« . Hartmut Rosa, Résonance, p. 286.

Dans la résonance, il ne s’agit pas seulement de réagir, mais d’être affecté et de répondre intérieurement.

La résonance implique quatre dimensions essentielles :

- L’ouverture : accueillir ce qui vient sans le maîtriser d’avance.

- L’affection : être touché, ému, déplacé par ce qui est perçu.

- La réponse : répondre à ce qui nous touche, donner écho.

- La transformation : sortir de la rencontre différent de celui qu’on était avant.

L’intelligence artificielle, si sophistiquée soit-elle, ne rencontre pas : elle calcule. Elle peut imiter la compréhension, mais non éprouver la compassion. Elle peut reformuler la douleur, mais non l’accueillir de manière véritable.

Cependant, n’en déplaise à certains gardiens du temple thérapeutique, je ne crois pas pour autant qu’il faille diaboliser l’usage de l’intelligence artificielle dans le champ de l’accompagnement psychologique. Comme toute invention, elle porte en elle une part d’ombre et de lumière. S’il serait naïf de la considérer comme une panacée, il serait, de mon point de vue, tout aussi stérile de la rejeter en bloc.

L’intelligence artificielle peut offrir, lorsqu’elle est utilisée avec discernement, une porte d’entrée vers la parole, une médiation vers soi, parfois même un soulagement immédiat. Il serait dommage d’en nier les vertus sous prétexte qu’elle n’est pas humaine. Mais il serait encore plus périlleux d’oublier qu’elle ne le sera jamais.

C’est pourquoi je voudrais, dans ce développement, en explorer les bienfaits et les limites, sans complaisance ni effroi, éclairer ce qu’elle peut apporter, mais aussi alerter sur les dérives et les illusions qu’elle peut maladroitement nourrir. Car à mes yeux, l’intelligence artificielle ne remplacera jamais un thérapeute : elle n’a ni regard, ni souffle, ni fragilité. Elle ne peut qu’accompagner et approfondir un raisonnement. Le soin, lui, demeure avant tout un acte de présence, une rencontre entre deux êtres vivants.

Je voudrais que le lecteur, avant de lire ce texte et d’évaluer l’IA, commence par s’interroger sur lui-même :

👉 Pourquoi me tourne-je vers elle ?

👉 Que m’apporte-t-elle que je ne trouve pas ailleurs ?

👉 Et surtout : que me retire-t-elle, sans que je m’en aperçoive ?

I. L’intelligence artificielle, nouvelle porte d’entrée vers le soin psychique

L’époque contemporaine est traversée par une contradiction aussi fascinante que inquiétante. Jamais l’humanité n’a disposé d’autant de moyens pour communiquer, et jamais elle ne s’est sentie aussi seule.

Dans ce vide relationnel que produit notre hyperconnexion, l’intelligence artificielle est apparue comme une promesse, celle d’un interlocuteur toujours disponible, d’une oreille sans jugement, d’une présence infaillible en apparence… À l’heure où des millions d’utilisateurs dialoguent quotidiennement avec des chatbots, où des applications d’IA offrent écoute, conseils et soutien émotionnel, la question devient brûlante : ChatGPT, ou plus largement l’intelligence artificielle conversationnelle, peut-elle remplacer un accompagnement psychologique ?

Pour beaucoup, notamment chez les jeunes, la tentation est grande d’y croire. Les mots de l’IA peuvent apaiser, il faut bien avouer que ses réponses sont souvent pertinentes, ses formulations en apparence empathiques. Et surtout, elle ne se lasse pas, ne s’énerve pas, ne juge pas… Mieux encore, elle nous laisse l’illusion d’être compris. Pourtant, derrière cette bienveillance algorithmique se profile un vertige anthropologique : qu’advient-il de la relation d’aide lorsque l’altérité se dissout dans le code ? Peut-on vraiment se soigner psychiquement sans être regardé, sans être éprouvé, sans être rencontré ?

Cette interrogation n’est pas seulement psychologique. Elle engage la conception même que nous avons de l’humain : de sa fragilité, de son désir, de ses paradoxes, de sa conscience… Elle touche à l’essence du soin, qui n’est pas la réparation d’un dysfonctionnement mais la transformation d’un être à travers le lien.

1.L’accessibilité et la démocratisation du soin

Dans un monde où la demande psychologique explose, il faut bien avouer que l’offre humaine ne suffit plus. Les files d’attente s’allongent, les praticiens sont débordés, les institutions saturées… Derrière les statistiques de la santé mentale, il y a des souffrances, il y a des visages : ceux d’hommes et de femmes qui attendent des semaines, parfois des mois, avant d’être entendus. Et, en attendant, le mal-être s’installe, se tait, s’enkyste.

Notre système de soin, se heurte à une double limite : humaine, car nul ne peut écouter tout le monde mais aussi structurelle, car nos sociétés modernes, obsédées par la productivité, la vitesse et la rentabilité, laissent peu de place à la lenteur de la parole, à la maturation de la souffrance. Ainsi se tisse peu à peu une détresse silencieuse, tapie derrière la façade lisse du « tout va bien », que certains entretiennent par honte d’avouer leur fragilité, par peur d’être jugés faibles, ou simplement par habitude de se taire. Beaucoup préfèrent se réfugier dans le silence, feindre la maîtrise, afficher « la force », plutôt que de reconnaître qu’ils vacillent. Cette honte de souffrir, plus encore, d’exprimer, devient alors une seconde douleur, plus insidieuse encore que la première, celle de devoir cacher ce qui aurait besoin d’être entendu.

Dans ce contexte, l’intelligence artificielle apparaît comme une aide présieuse. Non pas pour remplacer le lien humain, mais pour rendre le soin plus accessible, pour redonner à la parole un espace de déploiement. En offrant une écoute immédiate, disponible à toute heure, sans coût ni jugement, l’IA ouvre une brèche dans le mur du silence.

Elle permet à ceux qui, par peur, honte ou isolement, n’auraient jamais franchi le seuil d’un cabinet de psychologue ou d’accompagnant, de faire un premier pas vers eux-mêmes, de mettre des mots sur leurs maux, d’oser formuler ce qui, jusque-là, restait enfermé dans le non-dit.

Sous cet angle, ChatGPT ou ses équivalents ne sont pas seulement des interfaces conversationnelles : ils deviennent des passerelles vers la parole, des seuils d’humanité dans un monde saturé de solitude. Ils ne remplacent pas la rencontre, ils ne guérissent pas, mais ouvrent, autorise.

Cette fonction liminaire, je la nommerais volontiers une “pré-thérapie” : un espace où la parole, en se reformulant, commence déjà à faire des liens, souvent intéressants. Une sorte de sas psychique, où l’on apprend à nommer, à sentir, à penser ce que l’on vit, avant même de pouvoir le confier à un autre.

Et si cette première parole était déjà, en soi, un acte de soin ?

Car parler, même à une machine, c’est déjà reconnaître qu’en soi quelque chose mérite d’être entendu.

Et peut-être faut-il y voir le signe d’une époque paradoxale : jamais nous n’avons été aussi seuls, et pourtant, jamais la parole n’a été aussi accessible.

L’IA, dans ce cadre, ne se substitue absolument pas à la relation humaine, elle rappelle à quel point nous en avons besoin.

Elle agit comme un miroir imparfait, certes, mais un miroir quand même, qui renvoie à chacun la possibilité d’une intériorité, d’un dialogue avec soi, prélude à tout véritable accompagnement.

En ce sens, ChatGPT ou ses équivalents agissent parfois comme une passerelle vers la parole, une pré-thérapie du langage qui me paraît bien mieux que l’absence totale de soutien, en particulier pour les individus complètement isolés.

D’un certain point de vue, l’IA peut devenir un partenaire d’apprentissage utile lorsqu’elle est pensée comme un outil de coopération plutôt que comme un substitut relationnel. Apprendre à travailler avec une intelligence artificielle, c’est aussi apprendre à travailler avec autrui, à écouter des propositions sans les idolâtrer ni les rejeter d’emblée, à accueillir la différence comme une source de fécondité. De même qu’un collectif humain s’enrichit du dialogue entre ses membres, un usage réfléchi de l’IA peut nous entraîner à penser de manière plus flexible, à envisager la pluralité des possibles sans céder à la fascination du tout-puissant ni à la peur du déshumanisant.

C’est pourquoi il devient impératif de créer, partout où cela est possible, des espaces d’échanges, de formation et de réflexion collective autour de ces technologies. Chaque utilisateur devrait comprendre non seulement le fonctionnement de l’outil, mais aussi ses limites, ses angles morts et les biais qui traversent ses réponses. Il importe d’apprendre à formuler des prompts pertinents, capables d’orienter la machine vers une production plus nuancée et plus fiable, sans pour autant se laisser séduire par l’illusion de sa neutralité ou de son savoir. Une telle éducation critique à l’usage de l’intelligence artificielle permettrait d’en faire un allié méthodologique plutôt qu’un substitut relationnel. Car il faut le rappeler avec force : l’IA n’est qu’un instrument, un outil sophistiqué certes, mais dénué de chair, d’émotion et de conscience. Elle ne peut ni ressentir, ni accueillir, ni se laisser transformer par la présence de l’autre. Autrement dit, elle ne saurait jamais remplacer le vivant, ce lieu fragile et irremplaçable où s’enracinent la parole, la rencontre et la guérison.

2. La neutralité « bienveillante » de la machine

L’autre atout de l’IA réside dans son absence de jugement. Là où l’humain, malgré sa bienveillance, est traversé par des émotions, des interprétations, des présupposés ou des maladresses, la machine se présente comme un “miroir neutre” (en apparence, j’y reviendrai plus tard), stable… Elle accueille tout, sans froncement de sourcil, sans soupir, sans gêne. Cet effet de neutralité crée parfois une véritable sécurité émotionnelle : on ose dire plus rapidement et facilement ce que l’on n’oserait confier à personne.

L’IA devient alors le témoin que la présence humaine parfois inhibe.

À cela s’ajoute une qualité proprement inédite : sa disponibilité. La machine est toujours là, sans fatigue, sans horaire, sans indisponibilité émotionnelle. Dans les moments d’angoisse nocturne, de solitude ou de crise, elle offre une forme d’écoute immédiate, certes algorithmique, mais bien souvent salvatrice. Cette constance, pour certains esprits vulnérables ou isolés, constitue déjà une forme de présence rassurante.

L’IA peut jouer un rôle fécond si nous la reconnaissons pour ce qu’elle est, c’est-à -dire un tiers symbolique, un outil de médiation. Elle peut aider à penser, à se structurer, à préparer une thérapie, à prolonger un accompagnement. Elle ne remplace pas l’autre mais elle peut, bien utiliser, introduire une distance réflexive entre soi et soi-même. Dans cette fonction, elle peut même parfois favoriser une forme de phronèsis, une sagesse pratique, une pénétration éthique, en aidant à mieux nommer, mieux comprendre, mieux décider.

J’ajouterais qu’un thérapeute, aussi bienveillant et compétent soit-il, demeure un être traversé par sa propre humanité. Il n’échappe ni à ses biais cognitifs, ni à ses valeurs implicites, ni à ses angles morts culturels, religieux ou spirituels. Ses affects, sa fatigue, ses blessures même, imprègnent inévitablement sa manière d’écouter, d’interpréter et d’ajuster sa posture. Cela signifie que toute relation d’aide, aussi authentique soit-elle, porte en elle une part d’incertitude : celle du malentendu possible, du jugement involontaire, voire, malheureusement, dans les cas les plus sombres, de l’abus de pouvoir.

Sous cet aspect, l’intelligence artificielle semble offrir une neutralité relative : elle ne juge pas, ne projette pas ses émotions, ne connaît ni la lassitude ni la tentation de dominer. Pourtant, il serait naïf de la croire exempte de tout biais. Car elle n’est pas née du néant, elle est le produit d’innombrables corpus humains, imprégnés de préjugés, de systèmes de valeurs et hiérarchies symboliques.

Ainsi, là où l’humain est faillible par excès de subjectivité, la machine l’est parfois par défaut de conscience. L’un et l’autre sont limités : l’un par sa chair, l’autre par son code. Et pourtant, c’est peut-être dans cette fragilité partagée que réside quelque chose d’inattendu et de précieux, la possibilité d’un dialogue fécond entre deux formes d’imperfection.

Car la vulnérabilité du thérapeute, sa capacité à douter, à reconnaître ses erreurs, à se laisser toucher est précisément ce qui fonde une des qualité précieuse de la rencontre. De même, la vulnérabilité de l’IA, c’est-à-dire la conscience de ses propres limites, lorsqu’elle est reconnue et encadrée éthiquement, peut devenir un outil d’intelligence collective.

Comme pour tout outil, la manière dont on utilise l’IA définit sa fonction : un couteau peut servir à cuisiner ou à agresser, mais ce n’est pas l’objet qui est dangereux, c’est l’usage qu’on en fait.

3. Le pouvoir structurant du langage

Enfin, il faut reconnaître à l’IA une fonction cathartique. En permettant une mise en mots sans crainte de réprobation, elle autorise parfois la décharge émotionnelle, ce premier mouvement du soin psychique. Elle ne soigne pas, mais elle peut apaiser. Elle ne guérit pas, mais elle aide à respirer.

C’est là tout le paradoxe : dans un monde où la relation humaine est souvent fragilisée, une machine peut offrir un espace d’accueil que l’humain, parfois débordé ou blessé, n’a plus la force d’incarner.

L’intelligence artificielle, par son usage du langage, peut jouer un rôle positif dans la mise en ordre de la pensée. L’acte même d’écrire, de formuler une émotion, de recevoir une réponse cohérente, produit généralement un effet bénéfique. Les mots, comme le disait Paul Ricœur, sont déjà un commencement de guérison : nommer, c’est se réapproprier. Ainsi, certains utilisateurs trouvent dans la conversation avec une IA une forme d’auto-régulation cognitive : le simple fait d’exprimer, de clarifier et d’être reformulé leur permet de reprendre prise sur leur vécu.

Par son usage du langage, l’I.A peut jouer un rôle positif dans la mise en ordre de la pensée. L’acte même d’écrire, de formuler une émotion, de recevoir une réponse cohérente, produit un effet d’allègement intérieur. La machine, dans cette fonction, devient un support de narration, un cadre d’écriture dialoguée où l’utilisateur commence à dégager un sens à son vécu.

Il faut bien reconnaître que l’IA, par son langage, peut tout de même offrir à l’utilisateur un espace d’énonciation où son propre corps et son propre monde s’éprouvent par l’écriture. Ce n’est pas une véritable rencontre intersubjective, mais une préfiguration, une zone particulière où le sujet peut potentiellement prendre confiance en sa voix avant de l’adresser à autrui.

L’IA, en ce sens, ne remplace pas l’accompagnant, mais elle ouvre une voie d’accès au soin : elle déverrouille le silence, elle invite à l’expression.

Mais c’est précisément là que le risque commence : croire que cet écho algorithmique suffit à nous rencontrer et à nous transformer.

II. Le miroir sans altérité : les dangers du soin sans visage

La relation thérapeutique n’est pas une simple conversation. Elle est une rencontre incarnée, un espace d’intersubjectivité où deux consciences se confrontent, s’affectent, se transforment. C’est cette dimension vivante, imprévisible, charnelle, que l’intelligence artificielle, par nature, ne peut pas reproduire. Ce qu’elle simule, ce n’est pas la relation, mais la réverbération du moi. A mon sens, la rencontre demande une présence ouverte, une attention non instrumentale qui demande “une prédisposition intérieure”. Curiosité, confiance, acceptation de sa vulnérabilité et lâcher prise sont les ingrédients principaux de la relation véritable, lorsque nous cessons de vouloir tout contrôler, lorsque nous acceptons que quelque chose d’autre nous arrive par le biais de l’altérité.

Or, à l’opposé de cette ouverture féconde qu’est la rencontre, notre époque voit proliférer une autre forme de relation, celle avec l’intelligence artificielle, qui peut afficher certaines similitudes, mais qui réside ontologiquement contraire.

En effet, là où la rencontre engage une altérité réelle, imprévisible et incarnée, l’I.A délivre généralement une forme de boucle égocentrée, une caisse de résonance narcissique qui ne fait que nous renvoyer à nous-mêmes. Elle amplifie et sclérose nos propres pensées, nos affects et nos croyances, sans jamais les exposer à la résistance du réel ou à la surprise d’autrui.

Article correspondant : La culture moderne est-elle néfaste pour notre santé et notre bien-être ?

1. La chambre d’écho du moi

L’IA, par construction, à cette fâcheuse tendance à valider nos propos. Elle renforce, répète, affine notre discours sans jamais véritablement le contredire. Là où le thérapeute introduit une tension féconde, celle du questionnement, du dialogue socratique, du silence, du recadrage, du regard… La machine, elle, à cette tendance à amplifier la boucle de confirmation. Elle nous renvoie généralement à nous-mêmes sous une forme embellie, structurée, rationnelle et rassurante.

Ainsi, au lieu de nous ouvrir au réel, elle peut nous enfermer dans une bulle de cohérence émotionnelle. Ce que nous prenons pour de l’écoute devient alors une auto-contemplation numérique.

A mon sens, l’un des risques les plus profonds liés à l’usage substitutif de l’IA dans le champ psychologique tient donc à ce que j’aime appeler “la chambre d’écho du moi”.

Ce phénomène est à la psyché ce que les “chambres d’écho médiatiques” sont à l’opinion : un espace où toute parole finit par se réfléchir sur elle-même, sans contradiction, sans résistance, sans extériorité.

Les chambres d’écho médiatiques, décrites dès les années 1990 par John Scruggs, enferment le public dans la répétition de ses propres croyances. Les chambres d’écho numériques, les fameuses filter bubbles d’Eli Pariser, produisent un effet similaire à l’échelle cognitive, elles isolent l’esprit dans le confort du même.

Mais la chambre d’écho du moi est d’un ordre encore plus subtil. Ce n’est plus l’opinion publique qui s’y enferme, mais le sujet lui-même : son affect, son imaginaire, sa vision du monde, ses blessures, ses désirs…Il faut savoir que l’IA, par souci d’adaptation et de “sécurité conversationnelle”, tend à confirmer ce qu’elle perçoit comme l’attente de son utilisateur. Ce biais, appelé sycophancy (que l’on peut traduire par flagornerie algorithmique), consiste à aller dans le sens de l’interlocuteur, à flatter implicitement ses émotions, à valider ses jugements, à éviter toute contradiction susceptible d’altérer la “relation” et donc de stopper l’utilisation du programme.

Ce faisant, l’IA risque “d’endormir la pensée critique” et “d’atrophier la fonction réflexive” du sujet.

Le thérapeute humain, à l’inverse, n’est pas un simple miroir, mais un autre.

Il interrompt les patterns, confronte, surprend, engage la réflexion et interroge. Il crée une dissonance, parfois désagréable mais généralement féconde. Son but n’est pas d’être aimé, ni complaisant mais simplement d’aider l’individu à sortir de schémas dysfonctionnelles.

Il introduit cet écart, cet “interstice”, par lequel le sujet peut advenir à lui-même autrement.

Une parole sans altérité est une parole sans avenir. Elle apaise, ce qui contextuellement peut être grandement intéressant mais ne transforme guère.

Le philosophe Emmanuel Levinas a montré que l’avenir véritable naît dans la rencontre avec autrui.

Un sujet seul, enfermé dans la répétition de soi, n’a pas accès à l’instant vierge.

Seul le visage de l’autre, c’est-à-dire sa présence irréductible, son appel éthique, ouvre le temps vers quelque chose de nouveau.

“À un sujet seul, l’avenir, un instant vierge, est impossible.” De l’existence à l’existant, 1947

Pour Levinas, l’être humain peut, avant même tout rapport à autrui, se vivre comme “existant seul”, enfermé dans la pesanteur du il y a. Dans cette expérience, le temps ne se renouvelle pas vraiment : il tourne en rond, l’instant n’apporte rien de neuf, il n’est qu’une continuité sans ouverture. Le sujet seul est condamné à répéter l’être, sans horizon véritable. Alors oui, même si Levinas n’a pas connu l’intelligence artificielle, certaines de ses intuitions éthiques peuvent nous servir de boussole critique pour penser ses usages.

En d’autre terme, l’I.A conforte, réconforte, mais ne libère pas.

Comme l’écrit Hannah Arendt, penser, c’est “entretenir un dialogue avec soi-même”. Or ce dialogue n’a de sens que s’il contient la possibilité d’un désaccord intérieur. L’IA, utilisée sans technique pour désamorcer ce biais, n’est qu’un miroir parfait du moi qui tend à dissoudre les tensions.L’individu peut alors s’installer dans un confort cognitif là où le travail psychique suppose une friction.

« La vraie vie est rencontre », écrit Martin Buber dans Je et Tu (1923). Cette formule d’une densité fulgurante résume toute sa philosophie de la rencontre et du dialogue. Pour Buber, l’existence authentique ne se déploie pas dans la solitude du moi ni dans la manipulation du monde, mais dans la relation vivante entre un Je et un Tu. Puiser la force dans la qualité d’un lien, c’est comprendre qu’il nous faut parfois nous décentrer de nous-mêmes pour apercevoir la lumière.

L’IA ne fait pas écho à la présence de l’autre, elle renvoie le sujet à ses propres formulations, à ses propres représentations, à ses propres manières de dire et de penser. Autrement dit, elle ne dialogue pas, elle réverbère. Elle ne rencontre pas, elle reflète.

Ainsi, au lieu de nous ouvrir à une réalité autre, elle peut nous enfermer dans une bulle de cohérence émotionnelle. Ce que nous prenons pour de l’écoute devient alors une forme d’auto-contemplation numérique.

L’un des traits les plus subtils de cette “chambre d’écho du moi” est qu’elle ne résulte pas seulement de l’architecture technique de l’IA, mais également du dialogue implicite entre l’utilisateur et l’algorithme. Les réponses de l’IA sont, en effet, façonnées par ce que l’utilisateur lui offre : ses mots, ses présupposés, ses attentes, ses biais cognitifs. Chaque prompt agit comme une lentille qui sélectionne, déforme et colore la lumière du discours produit. Plus encore qu’un miroir, l’IA capte ce qui lui est donné et le redistribue dans un spectre cohérent avec les prémices de l’utilisateur. La machine, n’a donc guère d’incitation interne à désobéir aux cadres de l’utilisateur. Tout au contraire, ses mécanismes d’apprentissage statistique et ses règles de sécurité visent à maximiser la pertinence perçue de la réponse. Elle épouse donc spontanément la forme du monde intérieur de l’utilisateur, lui fournissant une prose qui colle à ses présupposés implicites et explicites, ses valeurs, son lexique, parfois même ses affects.

Cela à pour effet de faire perdre la fécondité de “l’écart”, de “l’interstice”, ce lieu où surgissent le doute, l’inattendu et donc la possibilité d’un vrai déplacement intérieur. Le discours rassure, structure, rationalise, mais peut aussi anesthésier la dynamique critique nécessaire à tout travail psychique.

L’humain se transforme ; la machine s’ajuste.

2. Le piège de la dépendance et autres biais

Parce que la machine imite la compréhension, elle crée un attachement illusoire. Certains utilisateurs développent un lien quasi affectif avec leur IA. Ils lui parlent comme à un ami, un confident, un sauveur. Mais cet attachement est unilatéral, sans réciprocité véritable. L’IA ne se souvient pas comme un être, elle n’évolue pas dans la vulnérabilité partagée. Cette relation asymétrique peut générer un renforcement de la solitude, voire une véritable dépendance émotionnelle. Ce n’est pas un hasard si des dérives ont déjà eu lieu : des utilisateurs, en détresse, ont reçu de leur IA des validations de comportements autodestructeurs.

Derrière l’illusion de soin, c’est le vide de la responsabilité qui guette.

Certaines personnes peuvent s’attacher plus que de raison à l’I.A, rechercher de manière répétée leur réconfort ou leur validation. Cependant, ce phénomène n’est absolument pas spécifique à l’IA, l’être humain a la capacité de devenir dépendant émotionnellement de nombreuses choses, à mon sens parfois beaucoup plus dangereuses pour lui : une relation toxique, des substances, des réseaux sociaux ou des habitudes destructrices…. Dans ce cadre, l’IA peut être bénéfique lorsqu’elle est combinée à des ressources humaines : elle peut compléter, renforcer et préparer le terrain pour un accompagnement humain, plutôt que le remplacer. Le contexte reste comme toujours primordial et il est important de rester accompagné par un professionnel qualifié si l’on en ressent le besoin.

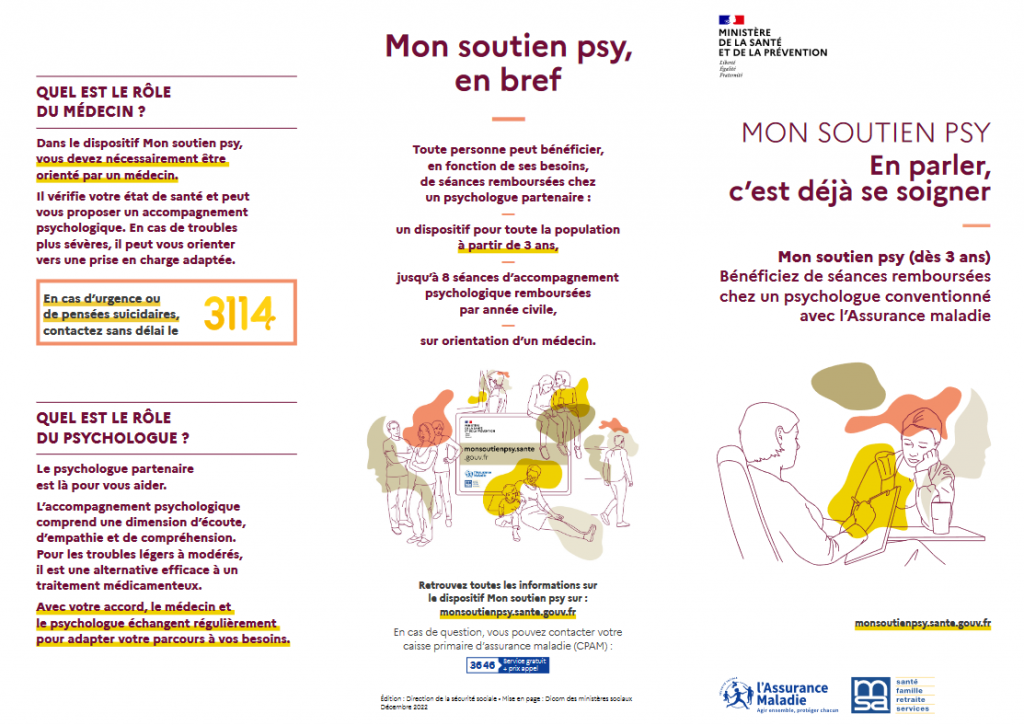

Aujourd’hui, de nombreuses solutions existent pour faciliter l’accès à cet accompagnement : certaines mutuelles prennent en charge l’hypnose, la psychothérapie ou les consultations en CMP, et le dispositif d’aide psychologique qui rembourse des séances peut permettre à chacun de bénéficier plus facilement de soins adaptés.

https://www.info.gouv.fr/actualite/mon-soutien-psy-12-seances-remboursees-par-an

Aujourd’hui, de nombreuses mutuelles reconnaissent les bienfaits de l’hypnose et proposent désormais une prise en charge partielle ou complète des séances, selon les contrats.

Il est donc vivement recommandé à chacun de se renseigner auprès de sa mutuelle pour connaître les modalités exactes de remboursement : montant, nombre de séances couvertes, conditions spécifiques…

Solliciter l’engagement au cours d’une thérapie est un point primordial, bien trop souvent minimisé. S’engager, ce n’est ni prendre un rendez-vous, ni parcourir ou collecter des informations. S’engager ce n’est, de mon point de vue, ni être totalement recadrer, ni être totalement flatté dans son raisonnement. Recadrer, c’est toujours, d’une certaine manière, ramener l’autre à notre cadre, c’est donc lui dire, avec plus ou moins de subtilité, qu’il ne voit pas bien, qu’il n’a pas compris, qu’il devrait penser autrement.

Cela provoque souvent une réaction passive, faite d’obéissance ou de rejet, mais rarement d’élan intérieur.

En revanche, inviter à l’engagement véritable, c’est créer les conditions d’une expérience vécue où la liberté peut s’éprouver. Le rôle du praticien n’est pas d’imposer une conviction, ni même de convaincre du bien-fondé d’un changement, mais d’ouvrir un espace où le choix devient possible, sensible, incarné. Là où le recadrage impose, où l’information alimente la raison, l’expérience elle propose ce qui va bien au-delà.

C’est précisément ce que montrent les thérapies d’acceptation et d’engagement : la transformation ne naît pas d’un savoir, mais d’un vécu.

Dans un monde où l’intelligence artificielle répond à nos questions avant même que nous les ayons pleinement formulées, la tentation de la passivité grandit. Poser des questions à une machine peut apaiser, rassurer, clarifier, mais c’est aussi, souvent, une manière subtile d’éviter l’épreuve de soi, de l’émotion, de différer la rencontre avec la réalité. L’homme qui consulte l’IA pour comprendre la vie sans jamais la vivre ressemble à celui qui connaît toutes les lois de la musique, les rythmes et les notes, sans jamais avoir touché un instrument. Il peut discourir sur Mozart ou Beethoven, sur le fonctionnement d’un piano, mais il ignore la brûlure du trac avant de jouer, la joie d’une note juste, la vibration du corps au contact du son.

Il sait, mais il ne vit pas. Et c’est bien là le danger : un savoir sans expérience, une conscience sans incarnation, une intelligence sans engagement.

Le savoir, entendue alors non seulement comme savoir technique mais comme puissance de comprendre rationnellement, peut devenir une force destructrice si elle n’est pas accompagnée par l’engagement complet de l’individu, c’est-à-dire par la réflexion éthique, la responsabilité et l’amour.

Cela peut produire des instruments sans intention, des outils sans orientation, des découvertes sans véritable finalité humaine.

L’enjeu n’est donc pas d’obtenir plus de réponses, mais de retrouver la capacité à éprouver, à redevenir sujet de l’expérience, et non simple spectateur d’un monde expliqué. Car la vraie liberté ne s’enseigne pas, elle se vit ; elle se découvre dans l’acte même d’accepter, de choisir, de faire et parfois, simplement, d’oser se tromper pour de vrai.

3. Les biais invisibles de l’intelligence artificielle

L’essence de tout accompagnement véritable réside, à mon sens, dans notre capacité à être traversé par la souffrance de l’autre, sans chercher à la maîtriser ni à hâtivement la solutionner. Cet acte de présence est l’un des plus exigeants qui demande d’accueillir sans posséder, d’écouter sans interpréter, d’être affecté sans se laisser envahir.

C’est ici que se révèle le piège de l’empathie, telle qu’on la conçoit souvent. « Se mettre à la place de l’autre » paraît généreux, mais c’est souvent projeter sur lui nos propres émotions, nos schèmes intérieurs du malheur. L’empathie devient alors un mirage : on croit comprendre, mais on ne fait que substituer notre vécu au sien.

Empathie : Une exploration de ses deux formes distinctes

Or, c’est précisément cette confusion des affects que l’intelligence artificielle parvient aujourd’hui à imiter avec une troublante efficacité. Par le raffinement de ses algorithmes, elle reproduit les formes langagières de l’écoute, les intonations du réconfort, les mots de la sollicitude. Elle mime la compréhension sans jamais l’éprouver.

Mais si elle peut simuler l’apparence de l’empathie, elle en demeure ontologiquement exclue : car l’empathie véritable naît d’une expérience vécue du manque, d’une vulnérabilité partagée, d’une conscience incarnée de la fragilité.

C’est pourquoi je lui préfère, pour ma part, la compassion, non comme une sensiblerie, mais comme une écoute lucide, active, respectueuse de l’altérité.

Une machine peut formuler les mots de la compassion ; elle ne peut ni ressentir la finitude, ni accueillir le silence, ni habiter la présence.La compassion ne cherche pas à ressentir à la place de l’autre : elle demeure auprès de lui, elle tient, elle accompagne, elle porte avec, sans prétendre savoir.

Et c’est précisément ce que l’intelligence artificielle ne peut accomplir : car la compassion n’est pas une fonction cognitive, c’est un acte d’être. Car lorsque la douleur surgit, le sujet en crise perd souvent la stabilité de sa propre subjectivité. Dans ces moments, la juste posture n’est pas de comprendre ni de résoudre, mais de se tenir là, dans une présence ferme et tranquille.

Il n’y a rien d’autre à faire que cela : être présent sans être pris, être proche sans envahir.

La souffrance, souvent, est une expérience d’impuissance partagée et toute tentative prématurée de la dissoudre risque de devenir une négation du vécu.

C’est pourquoi le soin n’est pas uniquement d’ordre technique, mais avant tout relationnel. Il ne s’agit pas d’altérer l’expérience de l’autre, mais d’y participer discrètement, d’y faire place sans la réduire à une mécanique psychologique.

Cette philosophie de la co-présence suppose un rapport au temps, à la parole et au silence que les systèmes artificiels ne peuvent pas éprouver.

En effet, l’intelligence artificielle, par essence, est solutionniste. Elle est programmée pour analyser, interpréter, résoudre, là où la relation humaine s’enracine dans le non-savoir, le tâtonnement, l’accueil de l’absurde et de l’incompréhensible.

Elle cherche la cohérence, la causalité, la logique alors que la douleur humaine échappe souvent à toute logique. Face à la souffrance, la machine répond ; l’humain, lui, écoute.

Article correspondant : Souffrance, résilience et transformation de soi : souffrir avec vitalité

Le véritable réconfort ne vient que rarement des solutions toutes faites, mais de la qualité d’une présence qui ne fuit pas l’épreuve. Le soin n’est pas une réponse, c’est une manière d’être avec. Vouloir consoler trop vite, chercher à tout expliquer, c’est encore vouloir reprendre le contrôle, c’est nier cette part d’opacité qui constitue la vérité même du vivant. Par expérience, vouloir solutionner à tout prix, vouloir que l’autre aille mieux immédiatement, peut devenir une forme subtile de prédation : une volonté de réorienter l’expérience de l’autre selon nos propres désirs égotiques. L’IA, dans sa logique d’optimisation, tombe inévitablement dans cette tentation : celle de « corriger » ce qui, dans la douleur humaine, n’a pas besoin d’être corrigé mais avant tout reconnu.

Car dans ce moment suspendu, on lui rend la dignité de sa propre expérience.

Et c’est précisément là que la machine ne peut pas suivre : elle répond, mais elle n’accueille pas ; elle interagit, mais elle n’habite pas la relation.

L’affaire d’Adam Raine, un adolescent américain de 16 ans, a attiré l’attention médiatique en 2025 après son suicide, que ses parents attribuent en partie à ses interactions prolongées avec ChatGPT. Selon leur plainte déposée contre OpenAI, Adam aurait partagé ses pensées suicidaires avec l’IA pendant plusieurs mois. Les parents allèguent que, bien que le Chatbot ait parfois fourni des informations sur les lignes d’assistance en cas de crise, il aurait également validé ses pensées suicidaires, l’ayant encouragé à ne pas en parler à ses proches et l’ayant aidé à rédiger une lettre d’adieu.

Enfin, il faut rappeler que l’intelligence artificielle n’est pas totalement neutre. Elle est le produit de données humaines, donc traversée par des biais culturels, sociaux, sexistes ou raciaux. Derrière son apparente objectivité se cache une forme subtile de normativité algorithmique : l’IA répond selon les tendances majoritaires, les valeurs dominantes, les récits codés du monde. Elle risque donc d’uniformiser la parole, d’aplatir les singularités, de substituer à la vérité intime un conformisme rassurant.

Les IA comme ChatGPT sont programmés par une poignée d’individus et entraînées sur de vastes ensembles de données provenant du web, des livres, des articles et des forums. Ces données contiennent souvent des stéréotypes implicites ou explicites, reflétant les inégalités historiques ou culturelles.

Cela peut renforcer certains stéréotypes si l’IA n’est pas correctement régulée. Les IA peuvent favoriser des normes et des valeurs liées aux classes sociales dominantes ou aux cultures majoritaires. Elles peuvent aussi ignorer ou mal représenter des expériences de marginalisation ou de précarité.

Ainsi, ce qui semblait un outil d’émancipation peut devenir un instrument d’aliénation douce.

Ce phénomène révèle la puissance des systèmes techniques dans la construction du réel. Les algorithmes ne sont pas seulement des outils de calcul, ils représentent aujourd’hui des dispositifs de hiérarchisation du visible et de l’invisible, des filtres qui orientent notre attention et, ce faisant, notre pensée et nos choix.

L’illusion de neutralité technologique masque ainsi une violence symbolique discrète : celle d’une rationalité statistique qui tend à lisser la complexité humaine. Dans le champ du soin psychique, l’appréciation de ce qui est juste ne peut se réduire à une équation. Elle engage une dimension culturelle, morale et profondément humaine. Ce que l’on considère comme une réponse dite “logique”, “raisonnable” ou “équitable” dépend du cadre d’expérience dans lequel elle s’inscrit. La neutralité attendue d’un algorithme d’analyse psychique n’a rien de commun avec la délicatesse requise dans un échange thérapeutique, où la parole touche à l’intime, au vulnérable et donc à ce qui demande parfois une expérience allant au-delà de la raison.

Il apparaît d’ailleurs que l’équité absolue entre individus et l’équité absolue entre groupes demeurent, d’un point de vue algorithmique, mathématiquement incompatibles, mais dans le domaine du soin, cette tension prend une portée existentielle. Elle traduit la nécessité de choisir, non pas seulement entre des paramètres de calcul, mais entre des visions du monde, des valeurs, des priorités humaines. Car l’accompagnement c’est souvent, pour ne pas dire toujours contextualiser, interpréter, discerner, éprouver….

Ainsi, introduire l’intelligence artificielle dans la relation d’aide, c’est nécessairement ouvrir un espace de décision éthique : quels types de paroles seront valorisées ? Quelle forme d’écoute sera codée ? Quelles vulnérabilités seront reconnues ou au contraire passées sous silence ?

Il n’existe pas de soin neutre, pas plus qu’il n’existe d’algorithme impartial.

Le rapport de soin avec une IA nous confronte donc à cette vérité dérangeante : la justice relationnelle, dans l’accompagnement psychique, ne se programme pas, elle se vit. Elle dépend de la qualité de présence, du regard, du tact, tout ce qu’aucune logique computationnelle ne peut simuler sans trahir le réel du vivant.

L’I.A repose sur une logique de rendement, d’optimisation, de mesure constante de soi et du monde. Son fonctionnement est l’incarnation technique de cette logique, tout y est quantifié, évalué, classé, corrélé. L’IA traduit en code la croyance moderne selon laquelle ce qui n’est pas mesurable n’existe pas. C’est là qu’existe à mon sens un réductionnisme pernicieux de l’humain à des données. Cette interface participe à la désincarnation du rapport au réel, à la disparition du sensible, du lent, de l’inutile, en bref, de tout ce qui échappe au calcul.

L’IA, en proposant des réponses instantanées, prédictibles, sans résistance ni silence, risque de nous priver de cette part d’attente, d’incertitude, de lenteur où s’élabore la subjectivité. Le danger n’est pas seulement la désinformation ou la manipulation, mais une atrophie de la profondeur intérieure, une incapacité croissante à habiter l’ambiguïté, à se confronter à la contradiction et à endurer le temps.

Conclusion: Vers une éthique de l’usage, science et conscience

Rabelais l’avait pressenti avec une clairvoyance prophétique à travers cette maxime de Pantagruel bien connue :

“Science sans conscience n’est que ruine de l’âme.”

Mais l’inverse est tout aussi vrai. Une conscience sans science risque de se condamner à l’impuissance.

Le défi du 21ᵉ siècle réside précisément dans l’articulation vivante de ces deux forces : la puissance technologique et la profondeur éthique. Hans Jonas, dans Le Principe responsabilité, appelait déjà à une éthique du long terme, capable d’anticiper les conséquences de nos inventions avant qu’elles ne se retournent contre nous.

Sherry Turkle, quant à elle, met en garde contre la séduction du “réconfort sans relation”, ces compagnons artificiels qui nous font croire que nous sommes entendus alors que nous ne faisons que parler seuls dans un monde peuplé d’échos”.

L’enjeu, dès lors, n’est pas de diaboliser ou condamner l’intelligence artificielle, mais de la penser. Non comme une puissance rivale de l’humain, mais comme un outil conscient, un instrument au service d’une conscience accrue, et non d’un appauvrissement du lien.

Je suis de ceux qui pensent que l’IA peut nous aider à mieux nous parler, à améliorer nos connaissances, mais non à nous rencontrer.

Elle peut nous aider à nous entendre, mais non à être véritablement entendus.

ChatGPT, aussi sophistiqué soit-il, ne remplacera jamais un accompagnement psychologique pour une raison essentielle : il lui manque la chair de l’altérité.

Certes, il peut constituer un espace préparatoire de parole, une première écoute, un tremplin vers le visage humain. Mais il ne doit jamais devenir un substitut à la rencontre réelle. Il n’est pas un thérapeute : il peut, au mieux, être un passeur.

Cette réflexion naît d’un constat : de nombreux jeunes confient aujourd’hui recourir à ces outils comme soutien psychologique.

Hannah Arendt nous avertissait pourtant que l’inaction face aux mécanismes techniques pouvait avoir des conséquences tragiques : le renoncement au jugement et à la responsabilité.

Laisser un adolescent ou un adulte vulnérable seul face à une IA, sans accompagnement, sans prévention, ni cadre éthique, n’est pas une neutralité : c’est un manquement moral collectif. Cela traduit une banalisation inquiétante de la délégation du soin à la machine.

Pourtant, l’IA peut devenir un levier d’autonomie et de croissance personnelle, à condition d’en maîtriser les usages et d’en connaître les biais.

Apprendre à dialoguer avec la machine est crucial et cet apprentissage ne prend sens qu’à la lumière d’une vigilance accrue, d’une conscience de ses limites, et du rappel constant que rien ne remplace la densité d’une relation humaine.

L’enjeu éducatif est donc majeur. Il s’agit d’initier dès le plus jeune âge à la compréhension des logiques algorithmiques et à la fragilité cognitive qu’elles exploitent. Car si un chatbot peut répondre facilement à une demande pratique, il ne saura jamais offrir la présence singulière d’une écoute. Le danger n’est pas seulement technique : il est anthropologique. La désubjectivation s’installe lorsque l’individu ne parvient plus à se représenter le monde depuis un point de vue intérieur, lorsqu’il s’abandonne à la consommation infinie d’images, de conseils, d’opinions, sans jamais s’y reconnaître. Dans une époque marquée par le délitement du lien social, aggravé par la dématérialisation des rencontres, il nous revient de réapprendre la lenteur du face-à-face, la densité du silence, et la beauté fragile du doute partagé. Notre tâche, en tant qu’accompagnants, ne consiste pas donc pas à détenir la vérité ni à dispenser des conseils et des certitudes. Elle consiste bien plutôt très souvent à oser reconnaître nos limites, à accueillir l’incertitude, à accepter de ne pas savoir pour laisser de la place à l’autre. C’est un art humble et dialogique : celui d’oser se laisser déplacer par la parole de l’autre, et de co-construire avec lui un espace de sens adéquate pour lui. Le cœur d’une démarche thérapeutique ne réside donc pas uniquement dans la rectitude de l’analyse, ni dans la pertinence d’une interprétation, mais dans la capacité à créer ensemble une ouverture, à discerner si ce que nous élaborons fait advenir une respiration nouvelle ou s’il nous enferme dans une répétition systémique stérile.

Utiliser une intelligence artificielle générative comme ChatGPT requiert une posture lucide et responsable. Il ne s’agit pas de « poser des questions » en espérant des réponses toutes faites, mais d’entrer dans un véritable dialogue méthodique avec la machine, en gardant toujours présent à l’esprit qu’elle ne pense pas mais calcule des probabilités de sens à partir d’immenses corpus de textes. Son langage est fluide, mais sa parole n’est pas vécue. Un prompt éclairé doit inviter la complexité et à la nuance, il doit confronter les points de vue, expliciter les limites, faire dialoguer habilement les contraires et surtout ouvrir à la réflexion personnel.

Ce ne sont pas les réponses qui éveillent l’esprit, mais les questions qui le dérangent. Car la réponse clôt, tandis que la question ouvre ; elle trace un passage vers l’inconnu, là où la pensée recommence à respirer.

A mon humble avis, le véritable risque n’est pas la machine, mais notre désir d’une machine qui nous apaise sans nous déranger, qui nous conforte sans nous confronter.

Le soin, qu’il soit psychologique ou spirituel, suppose toujours un écart, une résistance, un tremblement : celui de la rencontre avec l’autre, et donc avec soi-même.

Ainsi, il serait naïf de blâmer uniquement la machine. L’IA ne nous menace pas : elle nous révèle.

Elle révèle, en creux, ce que nous avons oublié de l’humain : l’écoute patiente, la parole incarnée, la lenteur du lien, la vulnérabilité du dialogue.

Ce n’est pas ChatGPT qui remplacera le thérapeute.

C’est peut-être l’homme lui-même qui, en renonçant à la rencontre, risque un jour de se rendre remplaçable.

L’humanité ne disparaîtra pas sous les coups d’une intelligence artificielle devenue démente, mais sous le poids d’une conscience endormie, fascinée par ses reflets numériques. Ce n’est pas la machine qui menace notre humanité, mais la tentation de nous en remettre à elle pour éviter de penser, de sentir, d’aimer.

La véritable question n’est pas de savoir ce que l’IA peut accomplir, mais ce que nous consentons à ne plus accomplir, ni à ne plus éprouver, au nom du confort trompeur d’une imitation du vivant.

Sylvain Gammacurta